1. Einleitung & Motivation

1.1 Zielsetzung des Wikis

Das vorliegende Wiki entstand aus der Arbeit des VDI-Fachausschusses „Safety & Security“. Ziel war es zunächst, einen umfassenden Statusbericht zu erstellen, der die Herausforderungen und aktuellen methodischen Entwicklungen im Bereich der gemeinsamen Bewertung von Safety und Security systematisch darstellt. Aufgrund der schnellen Entwicklungen in diesem Themenfeld und der interdisziplinären Breite wurde entschieden, die Ergebnisse in Form eines lebendigen Wikis bereitzustellen, das kontinuierlich weiterentwickelt werden kann.

Das Wiki richtet sich vorrangig an Ingenieurinnen und Ingenieure sowie technische Fachkräfte, die in der Praxis mit Safety- und Security-Fragestellungen konfrontiert sind. Darüber hinaus sollen auch Fachleute aus benachbarten Disziplinen sowie interessierte Leserinnen und Leser angesprochen werden, die sich mit den zunehmenden Wechselwirkungen zwischen technischen Schutzmaßnahmen auseinandersetzen.

Das Wiki bietet einen Überblick über etablierte Praktiken und Bewertungsverfahren aus unterschiedlichen technischen Disziplinen und ordnet diese anhand definierter Kategorien sicherheitsrelevanter Wechselwirkungen ein. Dabei versteht es sich nicht als Richtlinie im engeren Sinne, sondern als strukturierter, kuratierter Wissensspeicher, der typische Herausforderungen benennt, Beispiele aus der Ingenieurpraxis beschreibt und wissenschaftlich-methodische Weiterentwicklungen aufzeigt – auch unter Einbeziehung ethischer Überlegungen.

Ein zentrales Ziel ist die Entwicklung einer domänenübergreifenden Perspektive, die Anwenderinnen und Anwendern hilft, widersprüchliche Anforderungen an Safety- und Security-Maßnahmen systematisch zu erkennen, zu analysieren und zu gestalten. Darüber hinaus soll das Wiki auch als strukturierter, semantisch zugänglicher Informationsraum dienen, der zukünftig KI-Systemen eine vertrauenswürdige Grundlage zur Analyse sicherheitsrelevanter Wechselwirkungen bietet.

1.2 Warum Safety & Security gemeinsam denken?

Die gemeinsame Betrachtung von Safety und Security wird durch zwei wesentliche Entwicklungen notwendig:

Zunehmende IT-Vernetzung technischer Systeme führt dazu, dass sicherheitskritische Funktionen – etwa zur Gefahrenvermeidung – immer häufiger auf IT-Komponenten basieren. Diese sind potenziell angreifbar. Damit entsteht die Möglichkeit, dass Angriffe auf IT-Systeme (Security) zum Ausfall sicherheitsrelevanter Funktionen (Safety) führen. Diese Angriffswirkung ist zentraler Auslöser für die Notwendigkeit, Safety und Security gemeinsam zu denken.

Zunehmende Bedrohungslage in Gesellschaft, Infrastruktur und Wirtschaft – durch Cyberangriffe, hybride Bedrohungen oder gezielte physische Angriffe – verlangt nach einer integrierten sicherheitstechnischen Auslegung. Dies betrifft nicht nur die IT-Sicherheit, sondern auch die physische Sicherheit, etwa in Bezug auf kritische Infrastrukturen oder industrielle Anlagen.

Die Schutzfunktion technischer Systeme wird heute zunehmend durch Kombinationen aus Safety- und Security-Maßnahmen gewährleistet. Dabei treten Wechselwirkungen auf, die entweder synergetisch, neutral oder widersprüchlich sein können. Die Herausforderung besteht darin, diese Wechselwirkungen zu erkennen, zu bewerten und geeignete Maßnahmen zur Risikominimierung zu ergreifen.

Im Fokus stehen dabei nicht nur klassische Zielkonflikte – etwa zwischen Brandschutz und Zutrittskontrolle – sondern auch neue Herausforderungen durch die Integration von IT in sicherheitsrelevante Systeme. Die bisher übliche getrennte Betrachtung von Safety und Security greift hier zu kurz. Das Wiki verfolgt deshalb das Ziel, eine strukturierte, disziplinübergreifende Orientierung für die gemeinsame Bewertung und Gestaltung sicherheitsrelevanter Systeme zu schaffen.

1.3 Disziplinen

In diesem Abschnitt finden Sie zentrale Anwendungsbereiche der gemeinsamen Betrachtung von Safety & Security. Jede Disziplin bringt eigene technische, normative und methodische Herausforderungen mit sich. Ziel des Wikis ist es, diese disziplinspezifisch zu beschreiben und vergleichbar zu machen – anhand definierter Kategorien, Bewertungsansätze und typischer Zielkonflikte. Klicken Sie auf einen der folgenden Links, um mehr zu erfahren:

2. Grundlagen: Risiko, Safety, Security, Unsicherheiten

2.1 Begriff: Risiko

Die Grundlage der gemeinsamen Betrachtung von Safety und Security bildet ein einheitlicher Risikobegriff. Ziel ist es, eine risikobasierte Systematik zu etablieren, die Wechselwirkungen zwischen technischen Maßnahmen in beiden Domänen systematisch erfassen und bewerten kann.

Risiko wird dabei grundsätzlich verstanden als eine Kombination aus Eintrittswahrscheinlichkeit und Auswirkung eines unerwünschten Ereignisses. Dieses Basismodell eignet sich gut zur Beschreibung klassischer Safety-Szenarien, stößt jedoch im Bereich der Security auf methodische Grenzen: Während technische Versagenswahrscheinlichkeiten in der Regel probabilistisch abschätzbar sind (z. B. aus Erfahrungswerten oder Fehlermodellen), ist dies bei sicherheitsrelevanten Angriffsszenarien nicht der Fall.

Im Bereich Security basiert die Eintrittswahrscheinlichkeit eines Angriffs in der Regel auf menschlicher Willensbildung. Die damit verbundene Unsicherheit ist epistemischer Natur – also durch fehlende oder nicht zugängliche Information bedingt – und kann nicht probabilistisch im klassischen Sinne modelliert oder durch Verteilungsfunktionen dargestellt werden. Daher wird in der Security häufig mit qualitativen oder semiquantitativen Einschätzungen gearbeitet, oder auch durch separate Bewertung von Verwundbarkeiten.

Zur Beschreibung von Risiko in beiden Domänen haben sich unterschiedliche Modellierungen etabliert:

- Im Bereich Safety wird Risiko meist durch Eintrittswahrscheinlichkeit × Schadensausmaß beschrieben. In Normen wie IEC 61508 oder ISO 26262 führen diese zu gestuften Anforderungen (z. B. SIL, ASIL), die über die Verfügbarkeit von Sicherheitsfunktionen quantitativ nachgewiesen werden können.

- Im Bereich Security wird Risiko oft als Kombination von Bedrohung, Vulnerabilität und Auswirkung beschrieben. Die Bedrohungswahrscheinlichkeit selbst bleibt dabei meist unquantifiziert – stattdessen erfolgt eine qualitative Einschätzung unter Unsicherheiten.

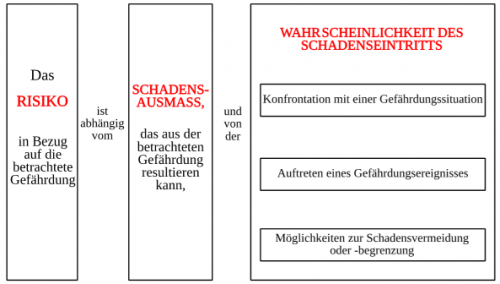

Abbildung 1: Dreigliedrige Darstellung von Safety- und Security-Risiko

Die zu ergreifenden Maßnahmen im Bereich Safety und Security – die hier in aller Regel technologischer Natur sind – sollen das Eintreten des sicherheitsrelevanten Ereignisses mit bestimmter Wahrscheinlichkeit verhindern, sei es im Fall einer äußeren Bedrohung (z. B. Angriff, Missbrauch) oder eines internen Elementarereignisses (z. B. Komponentenausfall, Bedienungsfehler).

Die Herausforderung einer gemeinsamen Betrachtung liegt in der methodischen Integration dieser beiden Perspektiven. Eine Möglichkeit besteht in einem dreigliedrigen Risikobegriff, in Anlehnung an den Bereich Security, der die unterschiedlichen Beiträge zum Risiko berücksichtigt und somit eine Grundlage für Maßnahmenbewertung und Entscheidungsfindung schafft.

2.2 Begriff: Safety

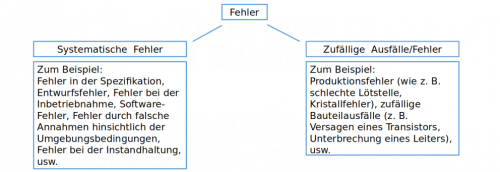

Safety-Risiken im Sinne dieser Dokumentation beziehen sich auf Risiken, die durch technische Systeme ausgelöst werden und Menschen, Umwelt, Sachwerte oder Infrastruktur gefährden können. Sie entstehen typischerweise infolge technischer Fehler, Komponentenausfälle oder unbeabsichtigter menschlicher Fehlhandlungen, z. B. durch Fehlbedienung oder mangelnde Wartung.

Ein wesentliches Merkmal von Safety-Risiken ist, dass ihre Eintrittswahrscheinlichkeit auf Basis von Erfahrungswerten probabilistisch abgeschätzt werden kann. In vielen Disziplinen der Safety werden Eintrittswahrscheinlichkeiten und Wirkungsfolgen (z. B. Personen- oder Umweltschäden) quantitativ modelliert und als Grundlage für das Sicherheitsdesign herangezogen – etwa über Methoden wie Fehlerbaumanalyse, HAZOP oder auch FMEA.

Typischerweise erfolgt eine zweistufige Bewertung: Gefährdungsanalyse (z. B. Risikograph, HARA), die die sicherheitsrelevanten Szenarien ermittelt und klassifiziert.

Nachweis der Wirksamkeit/Verfügbarkeit von Maßnahmen (z. B. über SIL- oder ASIL-Kategorien), die das Risiko auf ein vertretbares Maß reduzieren sollen.

Die zu ergreifenden Maßnahmen – zumeist technischer Natur – zielen darauf ab, die Wahrscheinlichkeit des Eintritts eines sicherheitsrelevanten Ereignisses bei einem bestimmten Auslöser (z. B. Fehler, Umwelteinfluss) zu verringern oder dessen Auswirkungen zu begrenzen. Die dafür eingesetzten Methoden sind in vielen technischen Normen und Regelwerken etabliert (vgl. Abschnitt 2.5.1).

Safety-Maßnahmen werden zunehmend durch IT-gestützte Komponenten realisiert, etwa Steuergeräte, Sensorik oder vernetzte Aktoren. Diese technologische Entwicklung begründet neue Verwundbarkeiten, die im Bereich der IT-Security verortet sind – und macht somit die gemeinsame Betrachtung von Safety und Security notwendig.

2.3 Begriff: Security

Security-Risiken entstehen durch vorsätzliche, zielgerichtete Handlungen, die auf die Beeinträchtigung oder Kompromittierung technischer Systeme und Infrastrukturen abzielen. Im Gegensatz zur Safety ist die Ursache also nicht zufällig oder unbeabsichtigt, sondern willensgesteuert – etwa durch Sabotage, Spionage, Terrorismus, Diebstahl oder Cyberangriffe.

Das zentrale Merkmal von Security-Risiken ist die epistemische Unsicherheit bezüglich ihrer Eintrittswahrscheinlichkeit: Da Angriffe von intelligenten Akteuren ausgehen, sind sie nicht probabilistisch erfassbar. Es existieren in der Regel keine belastbaren historischen Daten, die eine statistische Modellierung der sogenannten Bedrohungswahrscheinlichkeit erlauben würden. Aus diesem Grund wird bei Security-Risiken häufig nur die Vulnerabilität des Systems betrachtet – also die Verwundbarkeit bei gegebenem Angriff.

Security-Risiken lassen sich typischerweise in zwei Hauptbereiche unterteilen:

IT-/Cybersecurity, bei der Systeme über digitale Schnittstellen (Netzwerke, Software, Fernzugriffe) angegriffen werden.

Physische Sicherheit, bei der der Zugang zu bedrohten Systemen, Anlagen oder Einrichtungen durch physische Mittel (z. B. Einbruchswerkzeug, schwere Kfz) erlangt wird.

Ziel von Security-Maßnahmen ist es, die Verfügbarkeit, Integrität und Vertraulichkeit technischer Systeme zu schützen. Dazu werden Maßnahmen implementiert, die das Auftreten eines erfolgreichen Angriffs erschweren, detektieren oder seine Wirkung begrenzen – etwa über Zugangskontrollen, Firewalls, Verschlüsselung, Segmentierung, physische Barrieren oder organisatorische Maßnahmen.

Im Gegensatz zur Safety, wo die Risikobewertung oft quantitativ erfolgt, dominieren im Bereich der Security qualitative oder semi-quantitative Bewertungsverfahren (z. B. TARA-Analysen, Bedrohungskataloge, CVSS). Die Bewertung ist oft kontextabhängig und orientiert sich an Szenarien, Angreiferprofilen oder Schutzzielen.

Die zunehmende digitale Vernetzung technischer Systeme hat zur Folge, dass Security-Risiken zunehmend auch sicherheitsrelevante Funktionen betreffen – etwa wenn IT-Systeme, die Teil der Safety-Architektur sind, durch Cyberangriffe gestört oder manipuliert werden können. Dadurch entstehen relevante Wirkungen von Security auf Safety, die eine gemeinsame Betrachtung erforderlich machen.

2.4 Umgang mit Unsicherheiten

Im Rahmen sicherheitstechnischer Risikoanalysen spielen Unsicherheiten eine zentrale Rolle. Grundsätzlich lassen sich zwei Arten von Unsicherheiten unterscheiden:

Aleatorische Unsicherheiten, d. h. zufällige Streuungen (z. B. Ausfallraten, Umweltbedingungen), die durch Verteilungsfunktionen erfasst und mit probabilistischen Verfahren behandelt werden können.

Epistemische Unsicherheiten, d. h. Unsicherheiten aufgrund fehlender oder unvollständiger Informationen, etwa über die Wahrscheinlichkeit menschlichen Handelns oder die Existenz von Schwachstellen.

Mit aleatorischen Unsicherheiten kann man methodisch gut umgehen. In der Safety-Domäne sind bewährte Verfahren verfügbar: Monte-Carlo-Simulationen, die Berechnung von Vertrauensbereichen, varianzbasierte Sensitivitätsanalysen oder Bayessche Netze erlauben eine methodisch fundierte Risikoanalyse. Eine Abwägung verschiedener Risiken gegeneinander ist in diesem Rahmen prinzipiell möglich.

Im Security-Bereich dominiert jedoch epistemische Unsicherheit. Die Eintrittswahrscheinlichkeit von Security-Risiken hängt wesentlich von der Willensbildung potenzieller Angreifer ab und ist in der Regel nicht probabilistisch modellierbar. Damit versagen die klassischen Methoden der probabilistischen Risikoanalyse – etwa die Bewertung über Eintrittswahrscheinlichkeit × Auswirkung – im Security-Kontext weitgehend.

Konsequenz: In Fällen widersprüchlicher Anforderungen – etwa bei Zielkonflikten zwischen Safety und Security – ist eine Risikoabwägung methodisch kaum möglich, da eine quantitative Vergleichbarkeit der Risiken fehlt. Dies stellt eine wesentliche Herausforderung für die Auslegung sicherheitskritischer Systeme dar, die beide Domänen berücksichtigen müssen.

2.5 Beispiele für risikobasierte Modelle

2.5.1 Safety Modelle

- DIN EN ISO 13849: Sicherheit von Maschinen - Sicherheitsbezogene Teile von Steuerungen, 2017.

- DIN EN 61882 VDE 0050-8: HAZOP-Verfahren (HAZOP-Studien), 2017

- IAEA Safety Reports Series No. 25: Review of Probabilistic Safety Assessments by Regulatory Bodies, 2002.

- IAEA Safety Reports Series No. 52: Best Estimate Safety Analysis for Nuclear Power Plants: Uncertainty Evaluation, 2008.

- IAEA Safety Standards Series No. GSR Part 4 (Rev. 1): Safety Assessment for Facilities and Activities, 2016.

- IAEA Safety Standards Specific Safety Guide No. SSG-3: Development and Application of Level 1 Probabilistic Safety Assessment for Nuclear Power Plants, 2010.

- IAEA Safety Standards Specific Safety Guide No. SSG-4: Development and Application of Level 2 Probabilistic Safety Assessment for Nuclear Power Plants, 2010.

- IEC 61508: Funktionale Sicherheit sicherheitsbezogener elektrischer/elektronischer/programmierbarer elektronischer Systeme, 2011.

- IEC 61511: Functional safety - Safety instrumented systems for the process industry sector, 2016.

- ISO 26262: Road vehicles – Functional safety, 2018.

- NE 144: Risikobasierte Instandhaltung von Brandmeldeanlagen, 2012.

2.5.2 Security Modelle

- Alberts, Christopher, Audrey Dorofee, James Stevens, and Carol Woody. “Introduction to the OCTAVE Approach.” Networked Systems Survivability Program. Pittsburgh, PA, USA: Carnegie Mellon University, 2003.

- Beyerer, Jürgen, and Jürgen Geisler. “A Framework for a Uniform Quantitative Description of Risk with Respect to Safety and Security.” CKGE_TMP_i European Journal of Security Research CKGE_TMP_i 1 (2016): 135–150.

- BSI - Bundesamt für Sicherheit in der Informationstechnik. “Guidelines for Developer Documentation according to Common Criteria Version 3.1,” 2007.

- Campbell, Philip L., and Jason E. Stamp. “A Classification Scheme for Risk Assessment Methods.” SANDIA REPORT. Albuquerque, NM, USA: Sandia National Laboratories, 2004.

- Harnser Group, ed. “A Reference Security Management Plan for Energy Infrastructure.” European Commission, 2010.

- Landoll, Douglas J. The Security Risk Assessment Handbook: AComplete Guide for Performing Security Risk Assessments. 2nd ed. Boca Raton, FL, USA: CRC Press, 2011.

- NE 153: Automation Security 2020 - Design, Implementierung und Betrieb industrieller Automatisierungssysteme, 2015

3. Kategorien sicherheitsrelevanter Wechselwirkungen zwischen Safety und Security

Die zunehmende Vernetzung technischer Systeme sowie die veränderte globale Sicherheitslage machen eine gemeinsame Betrachtung von Safety- und Security-Maßnahmen erforderlich. Angriffe – insbesondere IT-basierte – können sicherheitsrelevante Funktionen direkt beeinträchtigen. Solche Angriffswirkungen sind konstituierend für die Notwendigkeit eines zusätzlichen Security-Layers und führen zu neuen Herausforderungen bei der Systemauslegung.

Im Rahmen dieses Wikis unterscheiden wir daher systematisch zwischen vier Typen sicherheitsrelevanter Designwechselwirkungen zwischen Safety und Security. Diese ergeben sich aus der Art der Beziehung zwischen den Anforderungen beider Domänen sowie deren wechselseitiger funktionaler Beeinflussung:

| Kategorie | Beziehungsart der Anforderungen | Relevante Designwechselwirkung | Richtung der Beeinflussung | Beispielhafte Betrachtung |

|---|---|---|---|---|

| 1 | kohärent oder konsistent | nein | keine | parallele Auslegung von Safety & Security |

| 2 | widersprüchlich | ja | Security → Safety (unidirektional) | IT-Security-Maßnahme verzögert Safety-Funktion |

| 3 | widersprüchlich | ja | Safety → Security (unidirektional) | Safety-Maßnahme erschwert Zutrittskontrolle |

| 4 | widersprüchlich | ja | bidirektional | Panikschloss: Fluchtszenario vs. Zutrittsverhinderung |

Hinweis: Die Angriffswirkung (Security Impact on Safety) ist unabhängig von der Designwechselwirkung und betrifft alle Kategorien, bei denen Safety-Funktionen auf IT-Systemen basieren. Sie ist konstituierend für die Notwendigkeit eines gemeinsamen Sicherheitsdesigns.

3.1 IT-Security Impact on Safety

Der hier beschriebene Fall entspricht der Kategorie 1 der sicherheitsrelevanten Designwechselwirkungen: Die Anforderungen aus Safety und Security sind kohärent oder konsistent – es bestehen keine widersprüchlichen Anforderungen.

Angriffswirkung auf Safety-Funktionen

Komplexe Sicherheitsfunktionen in technischen Anlagen und z. B. auch Automobilen sind oft zeitkritisch; ihre sichere Funktion hängt von der schnellen und sicheren Kommunikation in Netzwerken ab. Die allgegenwärtige und zunehmende Vernetzung macht die IT-Sicherheit zu einer der zentralen Herausforderungen der Zukunft.

Sicherheitsfunktionen stellen z. B. die rechtzeitige Abschaltung gefährdender Systeme oder Zugangsbeschränkung zu Gefahrenbereichen sicher und schützen somit Leben und körperliche Unversehrtheit. Die technische Umsetzung dieser Funktionen erfordert in der Regel Logik- oder IT-Systeme, die bei gegebener Vernetzung für Cyberangriffe vulnerabel sind.

Methodische Herausforderungen bei der gemeinsamen Bewertung

In gängigen Standards der funktionalen Sicherheit, wie IEC 61508 oder ISO 26262, werden quantitative Nachweise der Verfügbarkeit von Sicherheitsfunktionen gefordert – etwa über Ausfallwahrscheinlichkeiten und Diagnosebedeckung. Diese Metriken sind jedoch nicht kompatibel mit denen der IT-Security, da Eintrittswahrscheinlichkeiten für Cyberangriffe in der Regel nicht probabilistisch, sondern nur qualitativ abgeschätzt werden können.

Während sich Safety-Maßnahmen (z. B. SIL, ASIL) quantitativ über Fehlerraten und Zuverlässigkeitskennwerte belegen lassen, ist eine vergleichbare quantitative Bewertung von Security-Maßnahmen nicht möglich. Eine risikobasierte Abwägung zwischen den beiden Domänen ist daher in dieser Kategorie nur eingeschränkt möglich.

Da in dieser Kategorie keine widersprüchlichen Anforderungen bestehen, können Sicherheitsmaßnahmen für Safety und Security grundsätzlich unabhängig nebeneinander ausgelegt werden – vorausgesetzt, Angriffswirkungen auf Safety-Funktionen werden in der TARA (Security-Risikoanalyse) angemessen berücksichtigt.

3.2 Security Impact on Availability

Kritische Infrastrukturen (KRITIS) sind das Rückgrat moderner Gesellschaften. Die permanente Verfügbarkeit von Energie-, Wasser-, Kommunikations- und Verkehrsinfrastrukturen bildet die Grundlage unserer gesellschaftlichen und wirtschaftlichen Existenz. Infolge der zunehmenden Bedrohungslage – etwa durch hybride Angriffe oder gezielte Cyberattacken – rückt die Resilienz dieser Infrastrukturen verstärkt in den Fokus.

Dabei ist zwischen unterschiedlichen Bereichen kritischer Infrastrukturen zu unterscheiden:

- Bei physisch-technischen Infrastrukturen wie Strom-, Wasser- oder Verkehrssystemen sind Anforderungen an Verfügbarkeit (Availability) und Schutz vor Angriffen (Security) in der Regel konsistent. Die IT-Sicherheitsmaßnahmen zielen hier auf den Erhalt der Betriebsfähigkeit ab, ohne die Availability zu gefährden (Kategorie 1).

- Bei IT- und Telekommunikationsinfrastrukturen können sich hingegen Security-Maßnahmen negativ auf die Availability auswirken. Beispielsweise können Segmentierungen, Firewalls oder Verschlüsselungstechnologien durch Fehlkonfiguration oder Sperrmechanismen zu Verzögerungen oder Ausfällen führen (Kategorie 2).

Von Angriffen – ob terroristisch, kriminell, staatlich oder anderweitig motiviert – können sehr viele Menschen gleichzeitig betroffen sein. Wechselwirkungen zwischen physischer und IT-bezogener Security müssen daher berücksichtigt werden, etwa bei der Sicherung von SCADA-Systemen oder Rechenzentren. Dies erfordert die Entwicklung abgestimmter, semi-quantitativer Metriken zur Bewertung von Security-Maßnahmen unter Availability-Gesichtspunkten.

Lösungsansätze:

Ein belastbarer Lösungsansatz besteht in der abgestimmten Betrachtung von IT-Sicherheit, physischem Schutz und Verfügbarkeitsanforderungen in einer integrierten Analyse. Für physisch-technische Infrastrukturen steht der Erhalt der operativen Verfügbarkeit im Vordergrund. Für IT-/TK-Infrastrukturen hingegen sind spezifische Gegenmaßnahmen gegen Angriffe zu entwickeln, die die Verfügbarkeit nicht gefährden.

Die gesetzlichen Vorgaben – etwa das BSI-Gesetz, die KRITIS-Verordnung oder das neue KRITIS-Dachgesetz – fordern die Einhaltung des 'Standes der Technik'. Dieser ist jedoch interpretationsbedürftig und dynamisch. Die Entwicklung validierbarer Kriterien und abgestimmter Bewertungsskalen ist daher ein zentrales Forschungs- und Praxisziel.

3.3 Security Requirements Undermining Safety

In sicherheitskritischen Systemen kann es zu Situationen kommen, in denen Security-Anforderungen die Wirksamkeit oder rechtzeitige Ausführung von Safety-Funktionen behindern. Solche Fälle sind besonders kritisch, da der Schutz von Menschenleben durch Safety-Funktionen in der Regel oberste Priorität hat. Eine solche Konstellation stellt eine eigene Kategorie in der Betrachtung von Safety-Security-Wechselwirkungen dar, die sich von klassischen Angriffswirkungen (Security Impact on Safety) unterscheidet.

Während bei Angriffswirkungen die Kompromittierung durch eine externe Bedrohung erfolgt, geht es in dieser Kategorie um Designentscheidungen oder Sicherheitsanforderungen, die aus der Security-Domäne stammen und unbeabsichtigt Safety-Funktionen beeinträchtigen. Die Herausforderung liegt hier nicht in der quantitativen Risikobewertung, sondern in der szenariobasierten Analyse möglicher Konflikte und ihrer technischen Entkopplung.

Typische Szenarien

Verzögerung sicherheitskritischer Aktionen durch Authentifizierung: In IT-gestützten Safety-Funktionen kann eine starke Zugriffskontrolle (z. B. PIN, Token, Zwei-Faktor) im Notfall wertvolle Zeit kosten. Dies gilt z. B. für Sicherheitssysteme in der Industrie oder im Automotive-Bereich.

- Sicherheitsupdates beeinträchtigen Safety-Verfügbarkeit: Regelmäßige Software-Updates zur Schließung von Security-Lücken können Systemneustarts oder zeitweilige Nichtverfügbarkeit sicherheitskritischer Systeme erfordern.

- Netzwerksegmentierung unterbricht Safety-Kommunikation: Strikte Trennung von Netzwerken aus Security-Gründen kann zu unerwünschten Kommunikationsbarrieren führen, insbesondere bei verteilten Safety-Funktionen.

- Verschlüsselung verursacht Verzögerung oder Inkompatibilität: Wenn Safety-relevante Daten verschlüsselt übertragen werden, kann dies zu Verzögerungen oder Datenverlusten führen, z. B. in Fahrzeugnetzwerken oder verteilten Industrieanlagen.

- IT-KRITIS-Ausfall mit Safety-Folgen: Bei kritischen IT- oder Kommunikationsinfrastrukturen (z. B. GNSS, Zeitserver, SCADA-Netze) können Ausfälle auch sicherheitsrelevante physische Systeme betreffen. Diese Fälle wurden in Abschnitt 3.2 bereits behandelt.

Lösungsansätze In der Regel ist der Schutz von Menschenleben höher zu priorisieren als der Schutz technischer Systeme oder Daten. Deshalb sollte bei potenziellen Konflikten zwischen Security- und Safety-Zielen stets eine szenarienabhängige Entkopplung geprüft werden. Mögliche Maßnahmen umfassen:

- Einsatz technischer Entkopplungsmechanismen (z. B. sicherheitsgerichtete Bypass-Funktionen, notfallfähige Benutzeroberflächen)

- Entwicklung intelligenter Umschaltlogiken oder „Fail-Safe“-Strategien

- Klassifikation sicherheitskritischer Kommunikation als „prioritär“ in Netzwerken, auch unter Security-Randbedingungen

- Dokumentation und risikoorientierte Freigabe von Update-Zeitpunkten und Sicherheitsmaßnahmen

Die Designentscheidung sollte unter Berücksichtigung von Worst-Case-Szenarien getroffen werden, in denen Safety-Funktionen kompromittiert werden könnten. Eine rein technische Betrachtung reicht nicht aus – es ist auch eine ethische Bewertung erforderlich, wenn Zielkonflikte auftreten.

3.4 Safety Requirements Undermining Security

In der dritten Kategorie der Wechselwirkungen beeinflussen Anforderungen oder Maßnahmen aus dem Bereich Safety die Ausgestaltung und Wirksamkeit von Security-Maßnahmen. Diese Wechselwirkungen sind unidirektional: Eine Vorgabe oder Maßnahme aus der funktionalen Sicherheit schränkt Möglichkeiten zur Absicherung gegenüber gezielten Angriffen ein – z. B. durch Redundanzanforderungen, Notfallzugänge oder Entkopplung sicherheitskritischer Systeme.

Vorgeschriebene Notöffnungen vs. Zugangsschutz

In sicherheitskritischen Anlagen (z. B. Kernkraftwerke, chemische Industrie) kann eine Safety-Vorgabe erfordern, dass sich Türen bei Feuer oder Stromausfall automatisch öffnen müssen – unabhängig davon, ob eine unautorisierte Person gerade Zugang hätte. Dadurch wird ein zuvor sicherer Zugang (Security) durch eine Safety-Funktion untergraben.

Entkoppelung redundanter Systeme

Aus Safety-Gründen wird häufig Redundanz eingeführt (z. B. Redundanz bei Steuerungen oder Netzwerken). Wenn diese redundanten Systeme aus Safety-Sicht bewusst voneinander getrennt (entkoppelt) gehalten werden, können zentrale Security-Mechanismen wie eine durchgehende Zugangskontrolle oder einheitliches Patch-Management behindert werden.

Bypass-Schaltungen für Diagnose- oder Wartungszwecke

Für Wartung und Instandhaltung (oft aus Safety-Gründen) existieren oft Bypass-Schaltungen oder spezielle Zugriffsmöglichkeiten, die in Notfällen oder zu Diagnosezwecken aktiviert werden dürfen. Diese können potenziell ein Security-Loch darstellen, wenn sie nicht ausreichend abgesichert oder überwacht werden.

Mensch-Maschine-Schnittstellen mit Safety-Fokus

Bestimmte Anforderungen an Benutzerfreundlichkeit oder Erreichbarkeit von Not-Aus-Schaltern können Sicherheitsmaßnahmen wie Zugriffskontrolle (z. B. über PINs, Karten oder biometrische Daten) unterlaufen – z. B. weil eine schnelle Reaktionsfähigkeit als übergeordneter Safety-Wert gilt.

Priorisierung von Safety-Meldungen in Kommunikationsnetzen

In manchen Protokollen oder Echtzeitnetzwerken werden Safety-bezogene Datenpakete priorisiert übertragen, was zu Verzögerungen oder Paketverlusten bei Security-Meldungen führen kann (z. B. Alarmierung bei einem Einbruch oder Angriff).

Diese Beispiele zeigen, dass auch Safety-Anforderungen in bestimmten Konstellationen sicherheitsrelevante Wechselwirkungen hervorrufen können. Solche Szenarien sind sorgfältig zu prüfen – auch wenn die Priorisierung der Safety-Funktion in vielen Fällen gerechtfertigt ist, muss die potenzielle Schwächung von Security-Maßnahmen im Gesamtsystem mitgedacht werden.

Abwägung und Priorisierung

Auch wenn die Wahrscheinlichkeit und Relevanz solcher Szenarien geringer ist als bei der umgekehrten Wechselwirkung (Security Impact on Safety), sollte die Möglichkeit dennoch im Designprozess berücksichtigt werden – insbesondere in besonders kritischen Infrastrukturen wie der Kerntechnik.

Dabei gilt weiterhin die grundlegende Empfehlung: Der Schutz von Menschenleben (in diesem Kontext: Safety) hat in sicherheitsrelevanten Anwendungen grundsätzlich Vorrang. Security-Maßnahmen dürfen die Wirksamkeit von Safety-Funktionen nicht kompromittieren – aber umgekehrt ist auch zu vermeiden, dass Safety-Maßnahmen potenzielle Sicherheitslücken verursachen oder Schutzmechanismen im Bereich Security unterlaufen.

3.5 Contradicting Safety-Security Requirements

Die hier beschriebenen Konstellationen entsprechen Kategorie 4 – also Fällen widersprüchlicher Anforderungen an Safety- und Security-Funktionen mit potenziell sicherheitsrelevanten Wechselwirkungen. In diesen Fällen sind Safety- und Security-Ziele nicht gleichzeitig erfüllbar, sondern konkurrieren miteinander.

Ein klassisches Beispiel ist die Gebäudesicherheit: Fluchtmöglichkeiten im Brandfall (Safety) können durch verriegelte Türen (Security) behindert werden. Technische Maßnahmen wie Panikschlösser oder Pushbars dienen dazu, diese Anforderungen szenarioabhängig zu entkoppeln. Solche Lösungen ermöglichen eine automatische oder manuelle Umschaltung des Systemverhaltens je nach Bedrohungslage – etwa Feueralarm vs. Einbruch.

Ein besonders tragischer Fall eines ungelösten Zielkonflikts war der Absturz des Germanwings-Flugs 9525: Die Cockpittür war aus Sicherheitsgründen (Security) gepanzert und nicht aufzubrechen. Im Notfall kann sie mit einem Code von außen geöffnet werden (Safety), allerdings lässt sich dieser Mechanismus aus dem Cockpit heraus blockieren (Security). Dies führte dazu, dass die Crew den Suizid des Piloten nicht verhindern konnte – 150 Menschen starben. Dieses Beispiel illustriert eindrücklich die sicherheitsrelevanten Konsequenzen widersprüchlicher Anforderungen.

Auch in der Nukleartechnik entstehen Zielkonflikte: Maßnahmen gegen Sabotage (Security) können betriebliche Anforderungen an Redundanz oder Reaktionszeiten (Safety) beeinträchtigen. Derartige Widersprüche lassen sich nicht vollständig auflösen, sondern erfordern eine bewusste Abwägung.

Das Problem bei der Abwägung liegt vor allem in der Unsicherheit: Während aleatorische Unsicherheiten (z. B. bei Komponentenausfällen) probabilistisch modellierbar sind, handelt es sich bei der Eintrittswahrscheinlichkeit von Angriffen meist um epistemische Unsicherheiten – also um nicht objektivierbare Einschätzungen. Eine belastbare Risikoabwägung zwischen Safety und Security ist daher nur sehr eingeschränkt möglich.

Lösungsansätze bestehen unter anderem in der Entwicklung technischer Entkopplungsmechanismen und semi-quantitativer Bewertungsverfahren. Diese sollen dabei helfen, Prioritäten, Wirkungsgrade und Zielkonflikte nachvollziehbar zu machen. Letztlich müssen sicherheitsrelevante Entscheidungen jedoch immer auch ethische und gesellschaftliche Aspekte berücksichtigen.

Im Gegensatz zu Kategorie 1 (kohärente Anforderungen) und Kategorie 2 (unidirektionale Beeinflussung durch Security auf Availability oder Safety) sind die Zielkonflikte der hier betrachteten Kategorie 4 besonders komplex, da sie eine simultane, gleichwertige Betrachtung beider Schutzziele erfordern.

3.6 Cyberphysical Systems

Cyberphysische Systeme (CPS) sind Systeme, in denen physische Prozesse, IT-Komponenten und Kommunikationstechnologien so eng miteinander verknüpft sind, dass eine getrennte Betrachtung von Safety, IT-Security und physischer Sicherheit kaum noch möglich ist. Sie stellen nicht nur ein zentrales Anwendungsfeld für die kombinierte Sicherheitsbewertung dar, sondern fordern die etablierten Paradigmen der Sicherheit in ihrer Grundstruktur heraus.

Verwobene Sicherheitsdomänen

In CPS greifen Sicherheitsfunktionen aus allen Domänen – funktionale Sicherheit (Safety), IT-Security und physische Security – unmittelbar ineinander:

- Ein physischer Angriff auf ein Rechenzentrum oder SCADA-System kann systemweit alle IT- und Steuerungsfunktionen kompromittieren.

- Ein Cyberangriff auf eine Zugangskontrolle kann physische Sicherheitsmaßnahmen außer Kraft setzen.

- IT-gesteuerte Drohnenangriffe können etablierte physische Sicherheitsarchitekturen wie Zäune, Schleusen oder Perimeterüberwachung vollständig unterlaufen, bzw. überfliegen.

Globale Wirkung lokaler Störungen

Die immanente IT-Verknüpfung in CPS führt dazu, dass lokale Ereignisse globale Auswirkungen haben können:

- Ein Angriff an einem Netzknoten kann kritische Steuerungsprozesse in entfernten Regionen lahmlegen.

- Die Kopplung von Safety-Funktionen an IT-Systeme bedeutet: ein lokaler Security-Vorfall kann global sicherheitsrelevante Funktionen aushebeln – z. B. Notabschaltungen, Brandschutz, oder Verkehrsregelung.

Auflösung klassischer Sicherheitsgrenzen

Während frühere Sicherheitskonzepte meist klar zwischen physischen und digitalen Angriffsvektoren unterschieden, verwischen diese Grenzen zunehmend. Der Schutz technischer Systeme muss daher domänenübergreifend gedacht werden:

Lösungsansätze

Cyberphysische Systeme benötigen neue, integrative Ansätze, z.B.:

- Szenariobasierte Risikoanalysen, die Safety-, IT- und physische Risiken gemeinsam bewerten

- Kopplung etablierter Methoden (FMEA, Fault Tree, HARA, TARA) zu domänenübergreifenden Modellen

- Dynamisch adaptierbare Schutzstrategien, die im Notfall automatische Umschaltungen oder Priorisierungen erlauben

- Technische Mechanismen zur zuverlässigen Entkopplung von Szenarien

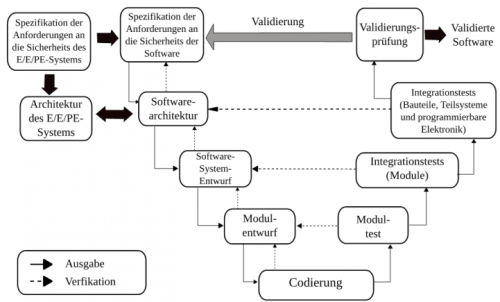

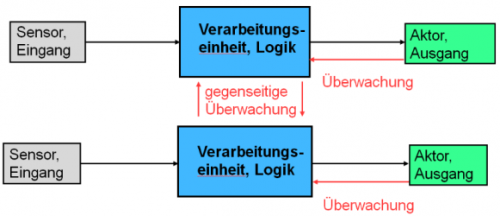

4. Funktionale Sicherheit

Die Funktionale Sicherheit ist ein zentraler Bestandteil der technischen Sicherheit von Maschinen und Anlagen. Sie bezieht sich auf Sicherheitsfunktionen, die durch Steuerungs- und Automatisierungstechnik realisiert werden, um Risiken systematisch zu mindern. Im Mittelpunkt steht die Beherrschung von Gefährdungen durch gezielte technische Maßnahmen, wie z. B. Sensorik, Logik und Aktorik, deren zuverlässiges Zusammenspiel essenziell ist, um gefährliche Situationen zu erkennen und darauf zu reagieren.

Dieser Abschnitt erklärt grundlegende Konzepte wie Risiko, Sicherheitsfunktionen, Ausfallwahrscheinlichkeiten (PFD/PFH), Safety Integrity Level (SIL), typische Fehlerarten und Schutzmaßnahmen. Dabei wird die Normenbasis (insbesondere IEC 61508) ebenso betrachtet wie konkrete Beispiele und bewährte Methoden zur Entwicklung sicherer Systeme.

→ Für detaillierte Inhalte klicken Sie auf „Mehr Informationen“.

5. Querschnittsthemen

Themen wie IT-Security, Resilienz und ethische Aspekte sind keine eigenständigen Disziplinen im engeren Sinne, sondern betreffen alle sicherheitsrelevanten Fachgebiete gleichermaßen. Sie wirken disziplinübergreifend, durchziehen technische, organisatorische und gesellschaftliche Fragestellungen und sind für jede Domäne – von der Automobilsicherheit bis hin zur kritischen Infrastruktur – von grundlegender Bedeutung.

5.1 IT-Security

Die Sicherheit informationstechnischer Systeme ist ein zentraler Aspekt moderner digitaler Infrastrukturen. In diesem Kapitel werden grundlegende Schutzziele, technische und organisatorische Maßnahmen sowie praxisnahe Ansätze zur Gewährleistung der IT-Sicherheit vorgestellt. Darüber hinaus wird ein Überblick über relevante Standards, rechtliche Rahmenbedingungen sowie domänenspezifische Herausforderungen gegeben, die im Kontext kritischer Systeme wie Automotive, KRITIS, Medizintechnik oder Embedded Systems besonders ins Gewicht fallen.

Ziel ist es, ein systematisches Verständnis für die Prinzipien, Methoden und Anforderungen der IT-Sicherheit zu vermitteln – sowohl aus theoretischer Sicht als auch mit Blick auf konkrete Umsetzungsstrategien in der Praxis.

→ Für detaillierte Inhalte klicken Sie auf „Mehr Informationen“.

5.2 Resilienz

Die Betrachtung der Resilienz ist motiviert durch die Annahme, dass nicht alle zukünftigen Gefährdungssituationen vorhersehbar sind, sondern dass im Gegenteil gerade besonders drastische Störereignisse plötzlich und unerwartet auftreten können. Die Auswirkungen solcher Ereignisse können nicht vollends abgefangen oder verhindert werden. Das Ziel von Resilienz-bildenden oder -stärkenden Maßnahmen ist es stattdessen ein System zu befähigen mit den Auswirkungen von Störungen jedweder Art und Ausprägung umzugehen – auch solcher, die bis zu ihrem Auftreten unbekannt waren.

→ Für detaillierte Inhalte klicken Sie auf „Mehr Informationen“.

5.3 Ethische Aspekte

Ethische Reflexionen spielen eine zentrale Rolle, wenn es um Fragen der Sicherheit geht – verstanden als Oberbegriff von Safety und Security. Denn Sicherheit betrifft nicht nur technische Machbarkeit, sondern auch Wertentscheidungen, Verantwortlichkeiten und gesellschaftliche Aushandlungsprozesse. Ethik hilft dabei, Orientierungen in komplexen Entscheidungssituationen zu entwickeln und Maßstäbe für verantwortungsvolles Handeln zu formulieren. Der folgende Text beleuchtet, wie sich sicherheitsrelevante Entscheidungen ethisch analysieren und begründen lassen. Im Mittelpunkt stehen vier wesentliche Dimensionen: kognitiv, normativ, prozedural und kommunikativ.

→ Für detaillierte Inhalte klicken Sie auf „Mehr Informationen“.

6. Leitfragen-Erläuterungen

Die folgenden zehn Leitfragen dienen dazu, die Beschreibung der einzelnen Disziplinen in eine einheitliche Struktur zu bringen. Alle Expertinnen und Experten wurden gebeten, ihre Disziplin entlang dieser Fragen zu beschreiben. Auf diese Weise lassen sich die Sichtweisen auf Risiko, Methoden, Dilemmata sowie mögliche Ansätze zur Auflösung von Zielkonflikten systematisch erfassen und vergleichen. Auch für neu aufzunehmende Disziplinen ist vorgesehen, dass sie anhand dieser Leitfragen dargestellt werden, um eine konsistente Erweiterung des Wikis zu ermöglichen.

Risiko: Definition und Herausforderungen

Frage: Wie wird das Risiko, werden Safety und Security in der Disziplin beschrieben: Begriffe, Modelle und Verfahren?

Diese Frage zielt auf die verwendeten Definitionen und theoretischen Konzepte ab: Wie wird Risiko modelliert (z. B. als Produkt aus Eintrittswahrscheinlichkeit und Schadensausmaß)? Welche Modelle und Verfahren sind etabliert (z. B. Bow-Tie, Fault Tree, Angriffsszenarien)? Wie unterscheiden sich Safety- und Security-Verständnisse?

Frage: Welche Probleme und Dilemmata sind in Ihrer Disziplin charakteristisch?

Hier geht es um typische Zielkonflikte, Unsicherheiten oder widersprüchliche Anforderungen, die in der Praxis auftreten – z. B. zwischen offener Bedienbarkeit (Safety) und Zugangsbeschränkung (Security).

Frage: Wie werden unscharfe oder unsichere Risikobeiträge behandelt?

Gefragt wird nach dem Umgang mit epistemischer Unsicherheit, fehlender Evidenz oder nur schwer quantifizierbaren Risiken – etwa durch Expertenabschätzungen, konservative Annahmen oder Sensitivitätsanalysen.

Durchführung von Risikoanalysen

Frage: Wie werden Risikoanalysen in Ihrer Disziplin durchgeführt (qualitativ, quantitativ, semi-quantitativ, nach Norm oder Richtlinie)?

Diese Frage betrifft die Methodik der Risikoanalyse – ob sie auf Zahlen basiert (quantitativ), auf Bewertungsskalen (semi-quantitativ) oder auf Expertenurteilen und Kategorien (qualitativ), sowie ob normative Vorgaben (z. B. ISO, IEC) genutzt werden.

Frage: Welche Metriken kommen hierbei zum Einsatz?

Hier geht es um die verwendeten Maßzahlen zur Risikobewertung, wie SIL (Safety Integrity Level), PL (Performance Level), CVSS (Common Vulnerability Scoring System) oder eigene branchenspezifische Kennzahlen.

Frage: Wie treten Wechselwirkungen der Domänen Safety und Security in der Risikoanalyse in Ihrer Disziplin in Erscheinung und wie werden diese behandelt?

Gefragt wird, ob und wie Abhängigkeiten oder Zielkonflikte zwischen Safety- und Security-Anforderungen explizit betrachtet und methodisch integriert werden – etwa durch kombinierte Modelle, Szenarien oder Priorisierungen.

Domänenübergreifende Zusammenführung

Frage: Werden in den angrenzenden Disziplinen ähnliche oder andere Probleme bearbeitet?

Diese Frage dient dem Vergleich mit benachbarten Disziplinen: Gibt es gemeinsame Herausforderungen (z. B. Unsicherheiten, Zielkonflikte)? Wo unterscheiden sich Herangehensweisen oder Prioritäten?

Frage: Was sind methodische Unterschiede und Gemeinsamkeiten in verschiedenen Domänen?

Diese Frage zielt darauf ab, innerhalb der jeweiligen Disziplin (z. B. Luftfahrt, Automotive, Energie, IT, physische Sicherheit) die Unterschiede und Gemeinsamkeiten der Methoden zur Risikoanalyse zwischen den Domänen Safety und Security herauszuarbeiten. Es soll untersucht werden, wie Risikoanalysen in beiden Bereichen jeweils durchgeführt werden – etwa hinsichtlich ihrer Modelle, Metriken, Normgrundlagen, Szenarioarten oder des Umgangs mit Unsicherheit – und ob sich daraus übertragbare Ansätze oder bestehende Zielkonflikte ableiten lassen. Ziel ist es, domänenübergreifende Schnittmengen zu identifizieren und Synergien oder Widersprüche systematisch zu dokumentieren.

Frage: Wie könnte ein gemeinsamer Nenner für die Quantifizierung von Risiken in Safety- und Security-Modellen aussehen?

Ziel dieser Frage ist es, Kriterien, Maße oder Modelle zu benennen, die domänenübergreifend genutzt werden können – etwa harmonisierte Risikokategorien, kompatible Skalen oder gemeinsame Indikatoren.

Frage: Welches neue Wissen ist erforderlich für eine Synthese der Domänen?

Abschließend wird nach offenen Forschungsfragen, neuen Kompetenzen oder interdisziplinärem Wissen gefragt, das notwendig ist, um Safety und Security systematisch zu integrieren – etwa zu Unsicherheitsbewertung, ethischer Abwägung oder Entscheidungsmodellen.